在当今的云计算时代,Kubernetes(k8s)已成为部署和管理应用的主流平台。而在 k8s 环境中,日志管理是至关重要的一环。EFK(Elasticsearch + Fluentd + Kibana)日志系统是一种常见的解决方案,它能够帮助我们收集、存储和分析日志数据,以便及时发现和解决问题。本文将详细介绍如何在 k8s 中搭建 EFK 日志系统,让您的日志管理更加高效。💡

一、引言

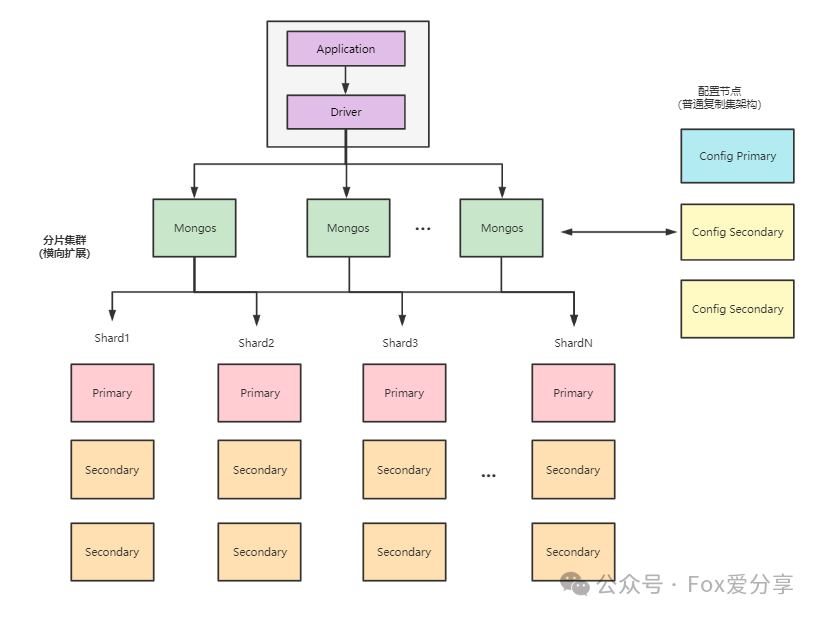

亲爱的读者们,想象一下您正在驾驶一艘巨大的轮船在海洋中航行。在航行过程中,轮船会产生各种各样的日志,这些日志记录了轮船的运行状态、故障信息等重要数据。如果没有一个有效的日志管理系统,您将很难及时发现和解决潜在的问题,可能会导致轮船出现故障甚至沉没。同样,在 k8s 环境中,应用也会产生大量的日志数据。这些日志数据对于我们了解应用的运行状态、排查故障、优化性能等都非常重要。因此,搭建一个高效的日志管理系统是必不可少的。EFK 日志系统是一种强大的日志管理解决方案,它由 Elasticsearch、Fluentd 和 Kibana 三个组件组成。Elasticsearch 是一个分布式搜索引擎,用于存储和索引日志数据;Fluentd 是一个日志收集器,用于收集应用的日志数据并将其发送到 Elasticsearch 中;Kibana 是一个可视化工具,用于查询和分析 Elasticsearch 中的日志数据。🎯

二、EFK 日志系统的优势

1. 分布式存储和索引:Elasticsearch 采用分布式架构,可以存储和索引大量的日志数据,并且能够快速查询和分析这些数据。

2. 强大的搜索和分析功能:Kibana 提供了强大的搜索和分析功能,用户可以通过图形界面轻松地查询和分析日志数据,快速定位问题。

3. 实时数据收集:Fluentd 能够实时收集应用的日志数据,并将其发送到 Elasticsearch 中,确保日志数据的及时性。

4. 易于扩展:EFK 日志系统可以很容易地扩展,以满足不断增长的日志数据量和查询需求。🤖

三、准备工作在开始搭建 EFK 日志系统之前,我们需要做好以下准备工作:

1. 一个运行中的 k8s 集群。

2. 对 k8s 集群有足够的权限,以便能够创建和管理资源。

3. 了解 YAML 格式的基本用法,以便能够编写和修改资源定义文件。

四、安装 Elasticsearch

1. 创建 Elasticsearch 的 Service Accountapi

Version: v1

kind: ServiceAccount

metadata:

name: elasticsearch

1. 创建 Elasticsearch 的 ClusterRoleapi

Version: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: elasticsearch

rules:

- apiGroups: [""]

resources: ["nodes", "pods"]

verbs: ["get", "watch", "list"]

- apiGroups: ["elasticsearch.k8s.elastic.co"]

resources: ["elasticsearches"]

verbs: ["get", "watch", "list", "create", "update", "delete"]

1. 创建 Elasticsearch 的 ClusterRoleBindingapi

Version: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: elasticsearch

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: elasticsearch

subjects:

- kind: ServiceAccount

name: elasticsearch

namespace: default

1. 创建 Elasticsearch 的 StatefulSetapi

Version: apps/v1

kind: StatefulSet

metadata:

name: elasticsearch

spec:

serviceName: elasticsearch

replicas: 1

selector:

matchLabels:

app: elasticsearch

template:

metadata:

labels:

app: elasticsearch

spec:

containers:

- name: elasticsearch

image: docker.elastic.co/elasticsearch/elasticsearch:7.12.0

resources:

limits:

memory: 2Gi

requests:

memory: 1Gi

ports:

- containerPort: 9200

- containerPort: 9300

env:

- name: "discovery.type"

value: "single-node"

volumeMounts:

- name: elasticsearch-data

mountPath: /usr/share/elasticsearch/data

volumes:

- name: elasticsearch-data

emptyDir: {}

1. 创建 Elasticsearch 的 Serviceapi

Version: v1

kind: Service

metadata:

name: elasticsearch

spec:

selector:

app: elasticsearch

ports:

- port: 9200

targetPort: 9200

五、安装 Fluentd

1. 创建 Fluentd 的 DaemonSetapi

Version: apps/v1

kind: DaemonSet

metadata:

name: fluentd

spec:

selector:

matchLabels:

app: fluentd

template:

metadata:

labels:

app: fluentd

spec:

containers:

- name: fluentd

image: fluent/fluentd-kubernetes-daemonset:v1.11.4-debian-elasticsearch7-1.0

resources:

limits:

memory: 200Mi

requests:

memory: 100Mi

volumeMounts:

- name: varlog

mountPath: /var/log

- name: fluentd-conf

mountPath: /fluentd/etc/fluent.conf

subPath: fluent.conf

volumes:

- name: varlog

hostPath:

path: /var/log

- name: fluentd-conf

configMap:

name: fluentd-conf

1. 创建 Fluentd 的 ConfigMapapi

Version: v1

kind: ConfigMap

metadata:

name: fluentd-conf

data:

fluent.conf: |

type tail

path /var/log/containers/*.log

pos_file /var/log/fluentd-containers.log.pos

tag kubernetes.*

read_from_head true

type kubernetes_metadata

type elasticsearch

host elasticsearch

port 9200

logstash_format true

index_name fluentd-kubernetes-${YEAR}.${MONTH}.${DAY}

六、安装 Kibana

1. 创建 Kibana 的 Deploymentapi

Version: apps/v1

kind: Deployment

metadata:

name: kibana

spec:

replicas: 1

selector:

matchLabels:

app: kibana

template:

metadata:

labels:

app: kibana

spec:

containers:

- name: kibana

image: docker.elastic.co/kibana/kibana:7.12.0

resources:

limits:

memory: 1Gi

requests:

memory: 500Mi

ports:

- containerPort: 5601

env:

- name: "ELASTICSEARCH_HOSTS"

value: "http://elasticsearch:9200"

1. 创建 Kibana 的 Serviceapi

Version: v1

kind: Service

metadata:

name: kibana

spec:

selector:

app: kibana

ports:

- port: 5601

targetPort: 5601

七、验证 EFK 日志系统

1. 查看 Elasticsearch、Fluentd 和 Kibana 的 Pod 状态 kubectl get pods -n logging 确保所有 Pod 都处于 Running 状态。

1. 发送一些日志数据 您可以在 k8s 集群中部署一个应用,并查看应用的日志是否被 Fluentd 收集并发送到 Elasticsearch 中。

2. 在 Kibana 中查询和分析日志数据 通过浏览器访问 Kibana 的 Service,您可以在 Kibana 中查询和分析 Elasticsearch 中的日志数据。🚀

八、实战案例:应用日志监控与分析假设我们有一个电商应用,部署在 k8s 集群中。我们希望使用 EFK 日志系统来监控和分析应用的日志数据,以便及时发现和解决问题。

1. 部署电商应用 在 k8s 集群中部署电商应用,并确保应用的日志输出到 /var/log/containers 目录下。

2. 查看日志数据 在 Kibana 中,您可以使用查询语句来查看电商应用的日志数据。例如,您可以查询所有错误日志:error: *

1. 分析日志数据 您可以使用 Kibana 的分析功能来分析电商应用的日志数据。例如,您可以分析日志数据的分布情况、趋势等。

2. 设置告警规则 您可以在 Kibana 中设置告警规则,当日志数据满足某些条件时,自动发送告警通知。例如,您可以设置当错误日志数量超过一定阈值时,发送告警通知。🌟

九、高级功能与拓展

1. 数据备份与恢复:您可以定期备份 Elasticsearch 中的数据,以防止数据丢失。如果数据丢失,您可以使用备份数据进行恢复。

2. 性能优化:如果日志数据量较大,您可能需要对 EFK 日志系统进行性能优化。例如,您可以调整 Elasticsearch 的配置、增加 Fluentd 的节点等。

3. 与其他系统集成:EFK 日志系统可以与其他系统集成,例如监控系统、告警系统等。您可以将 EFK 日志系统中的数据与其他系统进行关联,实现更加全面的监控和管理。🎉

十、总结

通过以上步骤,我们成功地在 k8s 中搭建了 EFK 日志系统。EFK 日志系统能够帮助我们收集、存储和分析日志数据,以便及时发现和解决问题。在实际应用中,您可以根据自己的需求对 EFK 日志系统进行定制和优化,以满足不同的日志管理需求。

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)