名称: l15y/wenda

地址: https://github.com/l15y/wenda

fork: 419 star: 3.3k 开发语言: CSS

简介: 闻达:一个 LLM 调用平台。旨在通过使用为小模型外挂知识库查找的方式,在不能涌现的前提下实现近似于大模型的生成能力

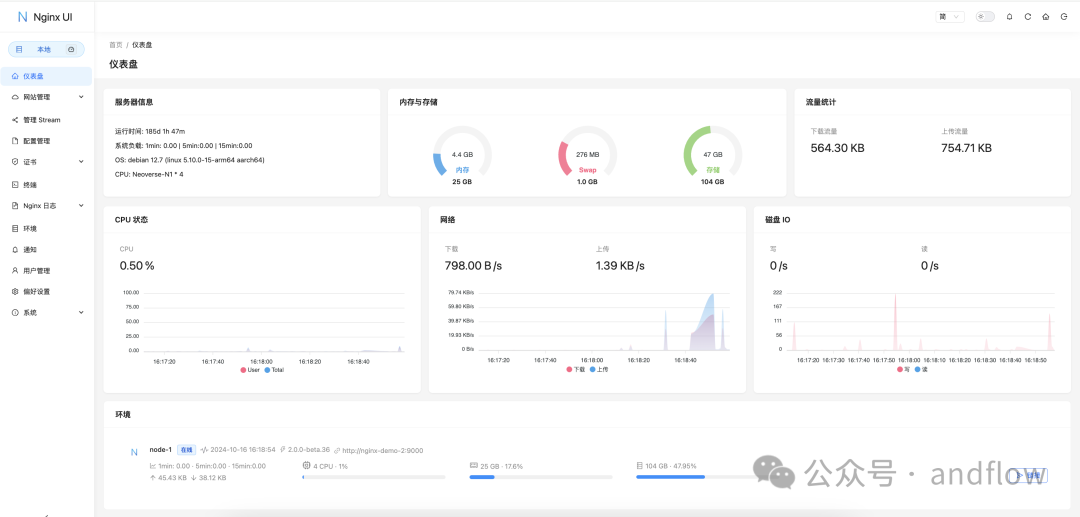

闻达(wenda)是一个 LLM 调用平台。旨在通过使用为小模型外挂知识库查找的方式,实现近似于大模型的生成能力,可以让我们在本地使用 GTX1660Ti(6G 显存)就能实现类似 GhatGpt 对话生成的功能。

技术特性

- 目前支持模型:chatGLM-6B、chatRWKV、chatYuan。

- 知识库自动查找

- 支持参数在线调整

- 支持chatGLM-6B、chatRWKV流式输出和输出过程中中断

- 自动保存对话历史至浏览器(多用户同时使用不会冲突)

- 对话历史管理(删除单条、清空)

- 支持局域网、内网部署和多用户同时使用。(内网部署需手动将前端静态资源切换成本地)

- 多用户同时使用中会自动排队,并显示当前用户。

功能

1. 设置和预设功能

安装使用

1.安装库

知识库索引模式:pip install -r requirements-sy.txt 知识库语义模式:pip install -r requirements-yy.txt

2.下载模型

根据需要,下载对应模型。

建议使用 chatRWKV 的 RWKV-4-Raven-7B-v7-ChnEng-20230404-ctx2048(截止到 4 月 6 日效果较好),或 chatGLM-6B。

3.参数设置

根据settings.bat中说明,填写你的模型下载位置等信息

4.生成知识库

将 txt 格式的语料放到 txt 文件夹中,运行run_data_processing.bat。

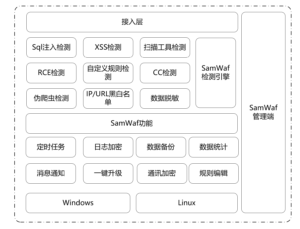

知识库

知识库最终效果是生成一些提示信息,会插入到对话里面。s 模式、x 模式首先要把 txt 目录下的文件喂给一个类似搜索引擎的东西,然后在对话过程中去查询这个搜索引擎获得提示信息;bing 模式、bingxs 模式则直接进行搜索获取答案。搜索后在回答之前插入提示信息,知识库的数据就被模型知道了。为防止爆显存,插入的数据不能太长,所以有字数限制。知识库在线模式:pip install -r requirements-bing.txt 主要是有以下几种方案:

- s 模式,基于 whoosh 搜索引擎,生成提示语。

- x 模式,基于 model/simcse-chinese-roberta-wwm-ext 模型,去生成提示语

- bing 模式,cn.bing 搜索,仅国内可用

- bingxs 模式,cn.bing 学术搜索,仅国内可用

- bingsite 模式,bing 站内搜索,需设置网址

调试工具

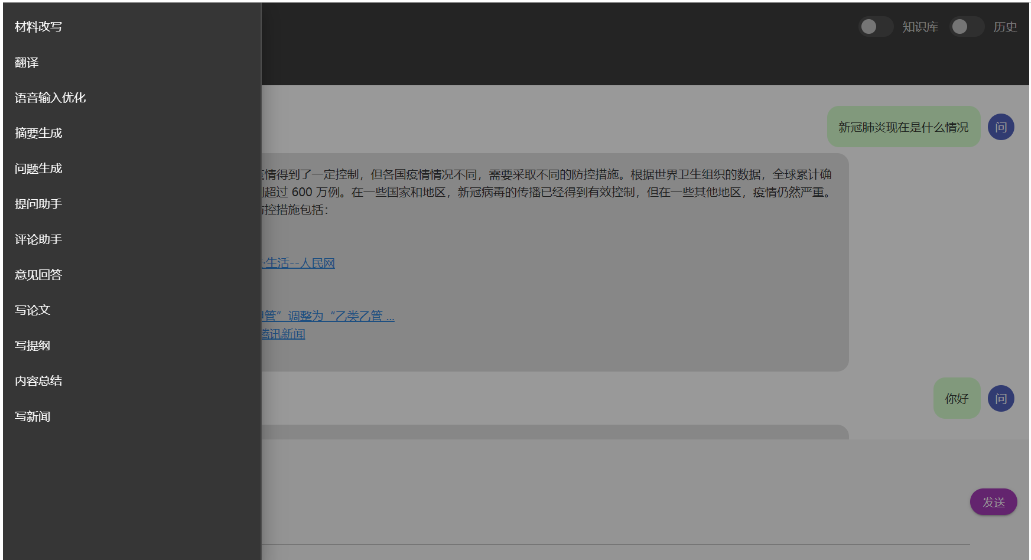

使用体验

1. chatGLM-6B 模型使用体验如下

2. chatRWKV 模型使用体验如下

3. 生成小说

更多内容,可以到 github 观看:https://github.com/l15y/wenda

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)