本文首先介绍 Nginx 的反向代理、负载均衡、动静分离和高可用的原理,随后详解 Nginx 的配置文件,带大家从原理到实战,彻底搞懂 Nginx!

图片来自 Pexels

Nginx 是开源的轻量级 Web 服务器、反向代理服务器,以及负载均衡器和 HTTP 缓存器。其特点是高并发,高性能和低内存。

Nginx 专为性能优化而开发,性能是其最重要的考量,实现上非常注重效率,能经受高负载的考验,最大能支持 50000 个并发连接数。

Nginx 还支持热部署,它的使用特别容易,几乎可以做到 7×24 小时不间断运行。Nginx 的网站用户有:百度、淘宝、京东、腾讯、新浪、网易等。

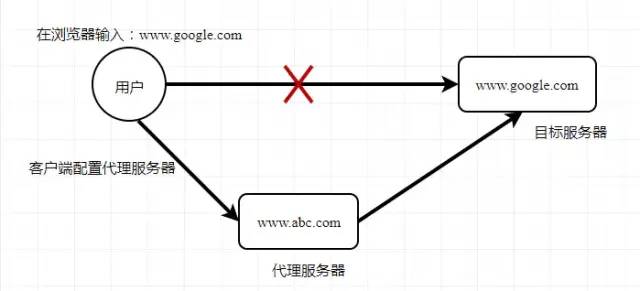

①正向代理

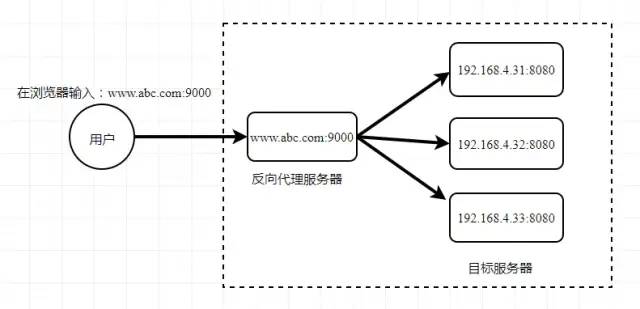

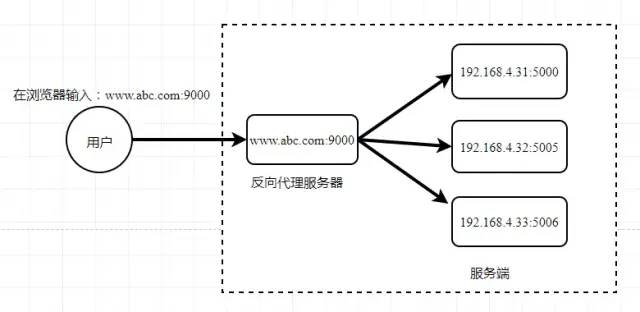

②反向代理

客户端对代理服务器是无感知的,客户端不需要做任何配置,用户只请求反向代理服务器,反向代理服务器选择目标服务器,获取数据后再返回给客户端。

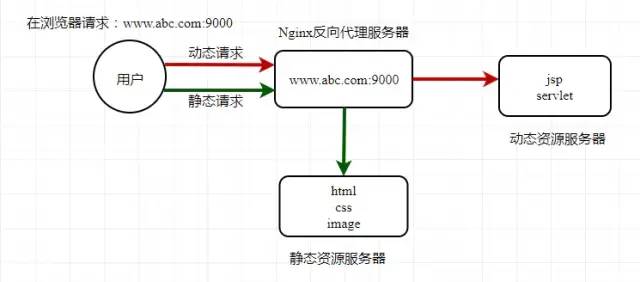

动静分离

Nginx 配置文件

①文件结构

... #全局块events { #events 块

…

}

http #http 块

{

… #http 全局块

server #server 块

{

… #server 全局块

location [PATTERN] #location 块

{

…

}

location [PATTERN]

{

…

}

}

server

{

…

}

… #http 全局块

}

Nginx 配置文件由三部分组成:

- 全局块,主要设置一些影响 Nginx 服务器整体运行的配置指令。比如:worker_processes 1;worker_processes 值越大,可以支持的并发处理量就越多。

- Events 块,涉及的指令主要影响 Nginx 服务器与用户的网络连接。比如:worker_connections 1024;支持的最大连接数。

- HTTP 块,又包括 HTTP 全局块和 Server 块,是服务器配置中最频繁的部分,包括配置代理、缓存、日志定义等绝大多数功能。Server 块:配置虚拟主机的相关参数。Location 块:配置请求路由,以及各种页面的处理情况。

②配置文件

########### 每个指令必须有分号结束。#################

#user administrator administrators; #配置用户或者组,默认为 nobody nobody。

#worker_processes 2; #允许生成的进程数,默认为 1

#pid /nginx/pid/nginx.pid; #指定 nginx 进程运行文件存放地址

error_log log/error.log debug; #制定日志路径,级别。这个设置可以放入全局块,http 块,server 块,级别以此为:debug|info|notice|warn|error|crit|alert|emerg

events {

accept_mutex on; #设置网路连接序列化,防止惊群现象发生,默认为 on

multi_accept on; #设置一个进程是否同时接受多个网络连接,默认为 off

#use epoll; #事件驱动模型,select|poll|kqueue|epoll|resig|/dev/poll|eventport

worker_connections 1024; #最大连接数,默认为 512

}

http {

include mime.types; #文件扩展名与文件类型映射表

default_type application/octet-stream; #默认文件类型,默认为 text/plain

#access_log off; #取消服务日志

log_format myFormat '$remote_addr–$remote_user [$time_local] $request $status $body_bytes_sent $http_referer $http_user_agent $http_x_forwarded_for'; #自定义格式

access_log log/access.log myFormat; #combined 为日志格式的默认值

sendfile on; #允许 sendfile 方式传输文件,默认为 off,可以在 http 块,server 块,location 块。

sendfile_max_chunk 100k; #每个进程每次调用传输数量不能大于设定的值,默认为 0,即不设上限。

keepalive_timeout 65; #连接超时时间,默认为 75s,可以在 http,server,location 块。upstream mysvr {

server 127.0.0.1:7878;

server 192.168.10.121:3333 backup; #热备

}

error_page 404 https://www.baidu.com; #错误页

server {

keepalive_requests 120; #单连接请求上限次数。

listen 4545; #监听端口

server_name 127.0.0.1; #监听地址

location ~*^.+$ { #请求的 url 过滤,正则匹配,~为区分大小写,~*为不区分大小写。

#root path; #根目录

#index vv.txt; #设置默认页

proxy_pass http://mysvr; #请求转向 mysvr 定义的服务器列表

deny 127.0.0.1; #拒绝的 ip

allow 172.18.5.54; #允许的 ip

}

}

}

配置实例

①正向代理

server{

resolver 8.8.8.8;

listen 80;location / {

proxy_pass http://$http_host$request_uri;

}

}

在需要访问外网的客户端上执行以下一种操作即可:

1. 方法1(推荐)

export http_proxy=http://你的正向代理服务器地址:代理端口 2. 方法2

vim ~/.bashrc

export http_proxy=http://你的正向代理服务器地址:代理端口

②反向代理

server {

listen 80;

server_name 192.168.4.32; #监听地址location / {

root html; #/html 目录

proxy_pass http://127.0.0.1:8080; #请求转向

index index.html index.htm; #设置默认页

}

}

实现效果:根据在浏览器输入的路径不同,跳转到不同端口的服务中。

具体配置:

server {

listen 9000;

server_name 192.168.4.32; #监听地址 location ~ /example1/ {

proxy_pass http://127.0.0.1:5000;

}

location ~ /example2/ {

proxy_pass http://127.0.0.1:8080;

}

}

- ~:表示 uri 包含正则表达式,且区分大小写。

- ~*:表示 uri 包含正则表达式,且不区分大小写。

- =:表示 uri 不含正则表达式,要求严格匹配。

③负载均衡

具体配置:

upstream myserver {

server 192.167.4.32:5000;

server 192.168.4.32:8080;

}server {

listen 80; #监听端口

server_name 192.168.4.32; #监听地址

location / {

root html; #html 目录

index index.html index.htm; #设置默认页

proxy_pass http://myserver; #请求转向 myserver 定义的服务器列表

}

}

轮询(默认):按请求的时间顺序依次逐一分配,如果服务器 down 掉,能自动剔除。

权重:weight 越高,被分配的客户端越多,默认为 1。

upstream myserver {

server 192.167.4.32:5000 weight=10;

server 192.168.4.32:8080 weight=5;

}

IP:按请求 IP 的 Hash 值分配,每个访客固定访问一个后端服务器。

upstream myserver {

ip_hash;

server 192.167.4.32:5000;

server 192.168.4.32:8080;

}

Fair:按后端服务器的响应时间来分配,响应时间短的优先分配到请求。

upstream myserver {

fair;

server 192.168.4.32:5000;

server 192.168.4.32:8080;

}

④Nginx 缓存

实现效果:在 3 天内,通过浏览器地址栏访问 http://192.168.4.32/a.jpg,不会从服务器抓取资源,3 天后(过期)则从服务器重新下载。

具体配置:

# http 区域下添加缓存区配置

proxy_cache_path /tmp/nginx_proxy_cache levels=1 keys_zone=cache_one:512m inactive=60s max_size=1000m;# server 区域下添加缓存配置

location ~ .(gif|jpg|png|htm|html|css|js)(.*) {

proxy_pass http://192.168.4.32:5000;#如果没有缓存则转向请求

proxy_redirect off;

proxy_cache cache_one;

proxy_cache_valid 200 1h; #对不同的 HTTP 状态码设置不同的缓存时间

proxy_cache_valid 500 1d;

proxy_cache_valid any 1m;

expires 3d;

}

⑤动静分离

upstream static {

server 192.167.4.31:80;

}upstream dynamic {

server 192.167.4.32:8080;

}

server {

listen 80; #监听端口

server_name www.abc.com; 监听地址

# 拦截动态资源

location ~ .*.(php|jsp)$ {

proxy_pass http://dynamic;

}

# 拦截静态资源

location ~ .*.(jpg|png|htm|html|css|js)$ {

root /data/; #html 目录

proxy_pass http://static;

autoindex on;; #自动打开文件列表

}

}

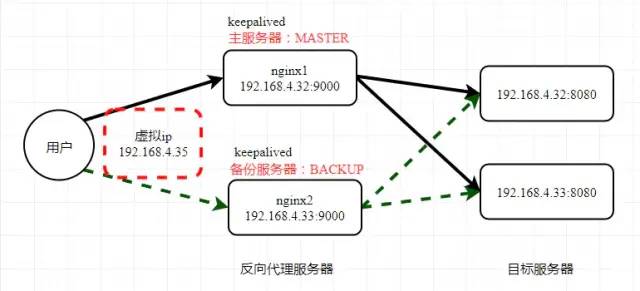

⑥高可用

# 安装 keepalived

yum install keepalived -y# 检查版本

rpm -q -a keepalived

keepalived-1.3.5-16.el7.x86_64

1.在两台 Nginx 服务器上安 Keepalived:Keepalived 相当于一个路由,它通过一个脚本来检测当前服务器是否还活着,如果还活着则继续访问,否则就切换到另一台备份服务器。

Keepalived 将 Nginx 服务器绑定到一个虚拟 IP,Nginx 高可用集群对外统一暴露这个虚拟 IP,客户端都是通过访问这个虚拟 IP 来访问 Nginx 服务器 。

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from_Alexandre.Cassen@firewall.loc

smtp_server 192.168.4.32

smtp_connect_timeout 30

router_id LVS_DEVEL # 在 /etc/hosts 文件中配置,通过它能访问到我们的主机

}vrrp_script_chk_http_port {

script “/usr/local/src/nginx_check.sh”

interval 2 # 检测脚本执行的时间间隔

weight 2 # 权重每次加 2

}

vrrp_instance VI_1 {

interface ens7f0 # 网卡,需根据情况修改

state MASTER # 备份服务器上将 MASTER 改为 BACKUP

virtual_router_id 51 # 主备机的 virtual_router_id 必须相同

priority 100 # 主备机取不同的优先级,主机值较大,备份机值较小

advert_int 1 # 每隔多长时间(默认 1s)发送一次心跳,检测服务器是否还活着

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.100 # VRRP H 虚拟地址,可以绑定多个

}

}

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

127.0.0.1 LVS_DEVEL

interval:设置脚本执行的间隔时间。

weight:当脚本执行失败即 Keepalived 或 Nginx 挂掉时,权重增加的值(可为负数)。

ens7f0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.4.32 netmask 255.255.252.0 broadcast 192.168.7.255

inet6 fe80::e273:9c3c:e675:7c60 prefixlen 64 scopeid 0x20<link>

... ...

3.在 /usr/local/src 目录下添加检测脚本 nginx_check.sh:

#!/bin/bash

A=`ps -C nginx -no-header |wc -l`

if [ $A -eq 0 ];then

/usr/local/nginx/sbin/nginx

sleep 2

if [ ps -C nginx -no-header |wc -l` -eq 0 ];then

killall keepalived

fi

fi

4.启动两台服务器的 Nginx 和 Keepalived:

# 启动 nginx

./nginx# 启动 keepalived

systemctl start keepalived.service

原理解析

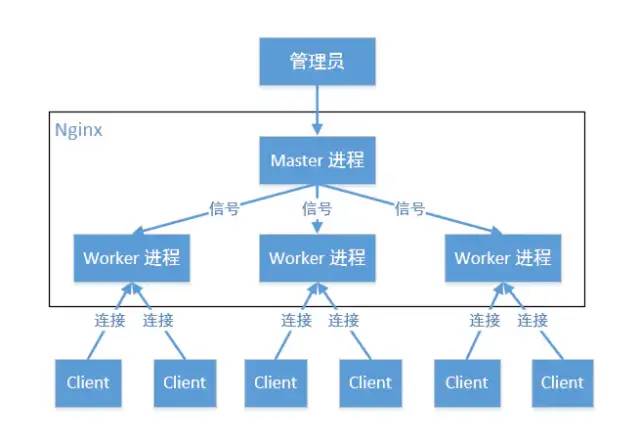

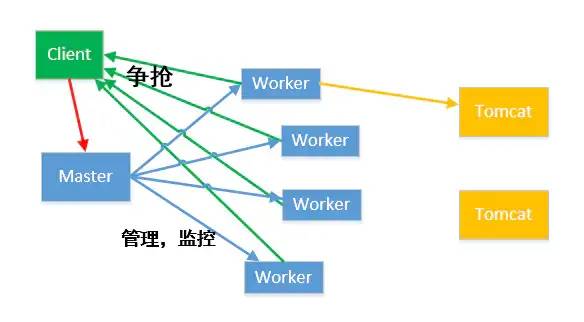

Master 作为管理员不参与任何工作,只负责给多个 Worker 分配不同的任务(Worker 一般有多个)。

ps -ef |grep nginx

root 20473 1 0 2019 ? 00:00:00 nginx: master process /usr/sbin/nginx

nginx 4628 20473 0 Jan06 ? 00:00:00 nginx: worker process

nginx 4629 20473 0 Jan06 ? 00:00:00 nginx: worker process

多个 Worker 以争抢的机制来抢夺任务,得到任务的 Worker 会将请求经由 Tomcat 等做请求转发、反向代理、访问数据库等(Nginx 本身是不直接支持 Java 的)。

- 可以使用 nginx -s reload 进行热部署。

- 每个 Worker 是独立的进程,如果其中一个 Worker 出现问题,其他 Worker 是独立运行的,会继续争抢任务,实现客户端的请求过程,而不会造成服务中断。

- 发送一个请求,会占用 Worker 几个连接数?

- 有一个 Master 和 4 个 Worker,每个 Worker 支持的最大连接数为 1024,该系统支持的最大并发数是多少?

作者:臧远慧

简介:就职于中科星图股份有限公司(北京),研发部后端技术组。个人擅长 Python/Java 开发,了解前端基础;熟练掌握 MySQL,MongoDB,了解 Redis;熟悉 Linux 开发环境,掌握 Shell 编程,有良好的 Git 源码管理习惯;精通 Nginx ,Flask、Swagger 开发框架;有 Docker+Kubernetes 云服务开发经验。对人工智能、云原生技术有较大的兴趣。

来源:https://juejin.im/post/5e1c263e5188254dc74a3b23

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)