一、概述

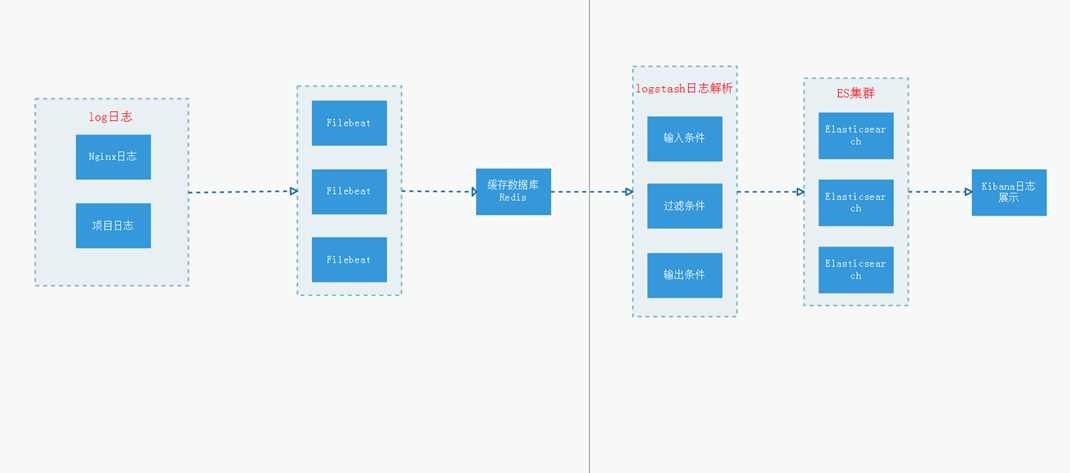

使用 ELK 收集 nginx access 日志,利用 Grafana 做出一套可视化图表

二、环境准备

环境说明

操作系统:centos 7.6

docker 版本:19.03.12

ip 地址:192.168.31.196

elk 搭建

关于 elk 的搭建,请参考以下 3 篇文章:

docker 安装 elasticsearch 和 head 插件

nginx 安装

线上 nginx 直接用 yum 安装的

yum install -y nginx

三、nginx 日志格式

默认的 nginx 日志格式,需要改为指定的格式

http {

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

log_format aka_logs

'{"@timestamp":"$time_iso8601",'

'"host":"$hostname",'

'"server_ip":"$server_addr",'

'"client_ip":"$remote_addr",'

'"xff":"$http_x_forwarded_for",'

'"domain":"$host",'

'"url":"$uri",'

'"referer":"$http_referer",'

'"args":"$args",'

'"upstreamtime":"$upstream_response_time",'

'"responsetime":"$request_time",'

'"request_method":"$request_method",'

'"status":"$status",'

'"size":"$body_bytes_sent",'

'"request_body":"$request_body",'

'"request_length":"$request_length",'

'"protocol":"$server_protocol",'

'"upstreamhost":"$upstream_addr",'

'"file_dir":"$request_filename",'

'"http_user_agent":"$http_user_agent"'

'}';

#access_log /var/log/nginx/access.log main;

access_log /var/log/nginx/access.log aka_logs;

注意:这里的 nginx 的所有访问日志,统一在/var/log/nginx/access.log。

如果你的环境,单独为每一个虚拟主机分配了 access 日志,那么就需要在对应的虚拟主机配置文件,应用格式 aka_logs 即可。

四、logstash 配置

注意:由于本文,直接使用 logstash 采集 nginx 日志,并发送给 elasticsearch。

如果是使用 filebeat 收集 nginx 日志,请查阅参考文章中的配置说明。

nginx.conf

新建文件 nginx.conf

/data/elk7/logstash/config/conf.d/nginx.conf

内容如下:

input {

file {

## 修改你环境 nginx 日志路径

path => "/var/log/nginx/access.log"

ignore_older => 0

codec => json

}

}

filter {

geoip {

#multiLang => "zh-CN"

target => "geoip"

source => "client_ip"

database => "/usr/share/logstash/GeoLite2-City.mmdb"

add_field => [ "[geoip][coordinates]", "%{[geoip][longitude]}" ]

add_field => [ "[geoip][coordinates]", "%{[geoip][latitude]}" ]

# 去掉显示 geoip 显示的多余信息

remove_field => ["[geoip][latitude]", "[geoip][longitude]", "[geoip][country_code]", "[geoip][country_code2]", "[geoip][country_code3]", "[geoip][timezone]", "[geoip][continent_code]", "[geoip][region_code]"]

}

mutate {

convert => [ "size", "integer" ]

convert => [ "status", "integer" ]

convert => [ "responsetime", "float" ]

convert => [ "upstreamtime", "float" ]

convert => [ "[geoip][coordinates]", "float" ]

# 过滤 filebeat 没用的字段,这里过滤的字段要考虑好输出到 es 的,否则过滤了就没法做判断

remove_field => [ "ecs","agent","host","cloud","@version","input","logs_type" ]

}

# 根据 http_user_agent 来自动处理区分用户客户端系统与版本

useragent {

source => "http_user_agent"

target => "ua"

# 过滤 useragent 没用的字段

remove_field => [ "[ua][minor]","[ua][major]","[ua][build]","[ua][patch]","[ua][os_minor]","[ua][os_major]" ]

}

}

output {

elasticsearch {

hosts => "192.168.31.196"

#user => "elastic"

#password => "password"

index => "logstash-nginx-%{+YYYY.MM.dd}"

}

}

注意 2 个位置:

/usr/share/logstash/GeoLite2-City.mmdb,这个是地图数据文件

elasticsearch {xx} 这里填写 elasticsearch 信息,由于我的 elasticsearch 没有开启认证,因此不需要用户名和密码,请根据实际情况填写。

GeoLite2-City.mmdb

GeoLite2-City.mmdb 是 IP 信息解析和地理定位的。

官网免费下载地址:https://dev.maxmind.com/geoip/geolite2-free-geolocation-data

github 下载地址:https://github.com/wp-statistics/GeoLite2-City

下载地址 1:https://pan.baidu.com/s/1sjtdvPV

备用下载地址:

链接:https://pan.baidu.com/s/1eJkDqq2nvV3vETyUfOBypw

提取码:2jq5

下载完成后,将此文件,上传到/data/elk7/logstash 目录,待会启动 logstash,就会挂载进去。

以新的方式启动 logstash

docker rm -f logstash

docker run -d \

--name=logstash \

--restart=always \

-p 5044:5044 \

-v /data/elk7/logstash:/usr/share/logstash \

-v /var/log/messages:/var/log/messages \

-v /var/log/nginx:/var/log/nginx \

logstash:7.5.1

等待 30 秒,查看 logstash 日志是否有错误

docker logs -f logstash

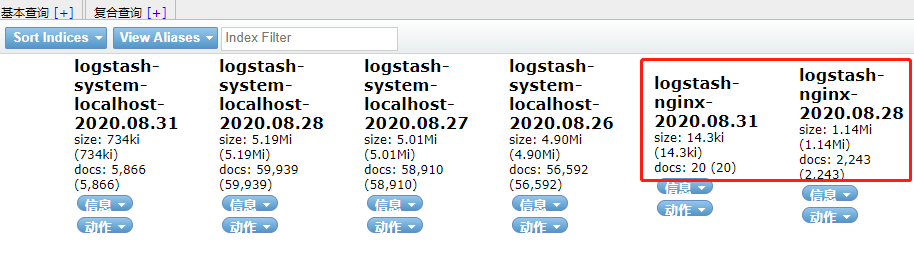

访问 head 插件,查看索引是否生成

http://192.168.31.196:9100/

有出现 logstash-nginx 索引,说明成功了。

五、Grafana 配置

关于 grafana 的安装,请参考链接:

https://www.cnblogs.com/xiao987334176/p/9930517.html

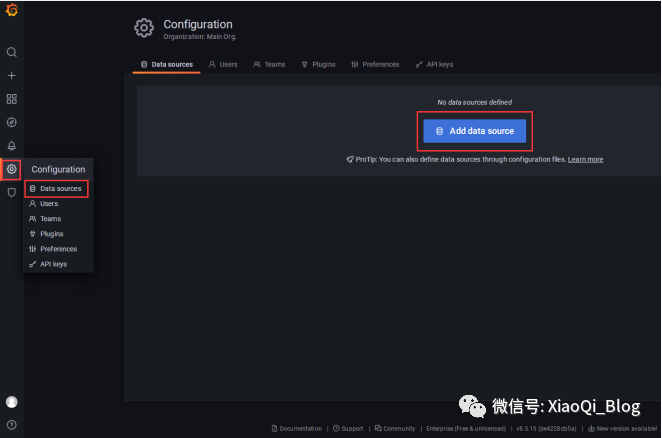

添加数据源

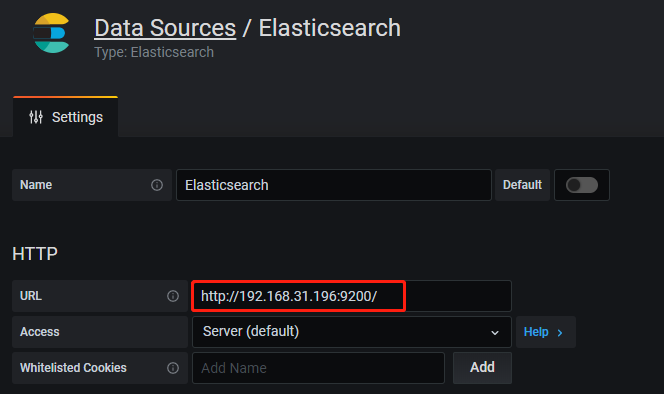

添加 elasticsearch 数据源,这里输入 elasticsearch 的 url

如果 elasticsearch 需要认证,在下面的 Auth 设置中,Basic auth 开启,输入用户名和密码。

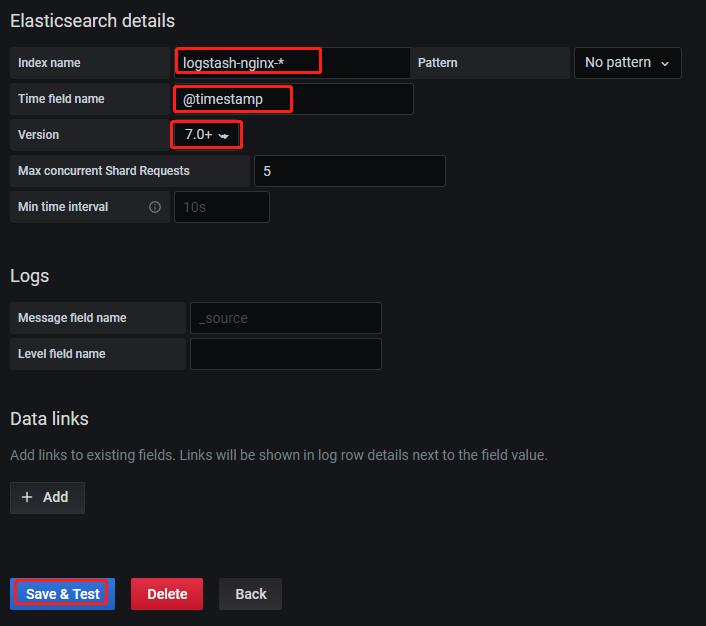

输入索引值,时间戳,选择版本:7.0+

如果测试通过,则会添加成功。

安装插件

进入 grafana 容器,安装 2 个插件,用来支持展示图表的。

grafana-cli plugins install grafana-piechart-panel

grafana-cli plugins install grafana-worldmap-panel

重启 grafana

docker restart grafana

导入模板

模板下载地址为:https://grafana.com/grafana/dashboards/11190

下载最新版本,导入 json 文件,选择 2 个数据源

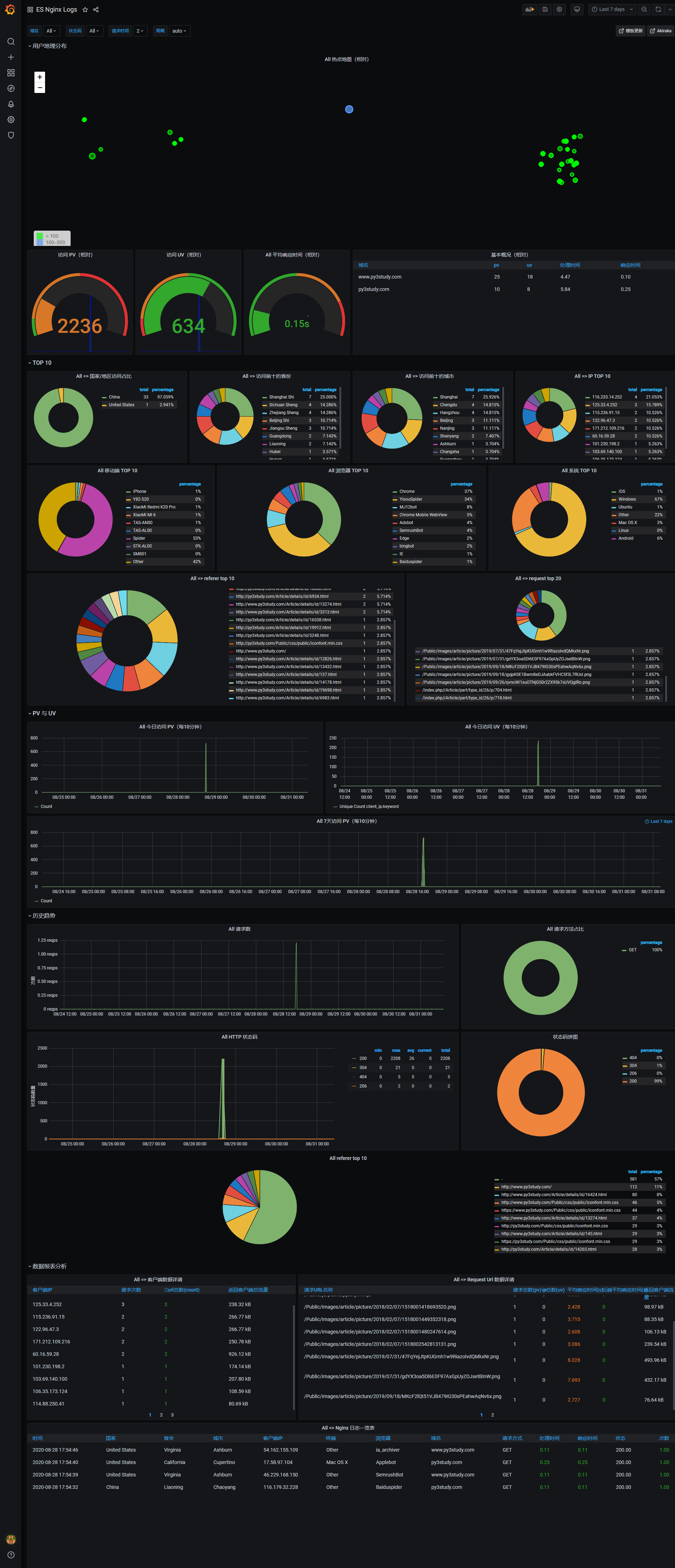

查看效果

刷新页面,效果如下:

本次参考链接:https://grafana.com/grafana/dashboards/11190-es-nginx-logs/

其他参考链接:https://grafana.com/grafana/dashboards/2292-elasticserch-nginx-logs/

https://grafana.com/grafana/dashboards/8919-node-exporter-dashboard-20240520-tensuns/

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)