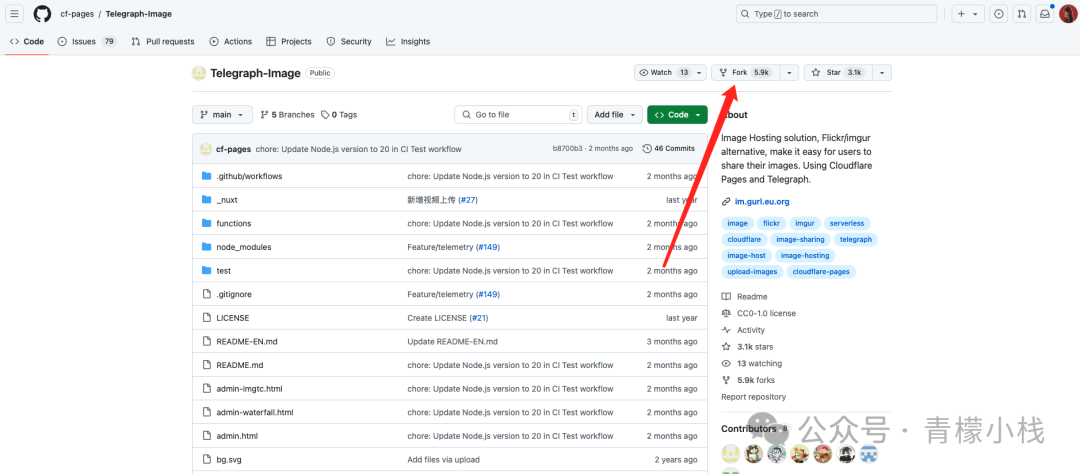

地址: https://github.com/SCIR-HI/Huatuo-Llama-Med-Chinese fork: 285 star: 3.1k 开发语言: Python

项目简介: Repo for HuaTuo (华驼), Llama-7B tuned with Chinese medical knowledge. 华驼模型仓库,基于中文医学知识的 LLaMA 模型指令微调 LLaMA 又被称为羊驼模型,全称是 Large Language Model Meta AI,是由 Meta 开源的大模型,其参数量从 70 亿到 650 亿不等。 在使用时,只需要输入身体状况的描述,本草 就能给出诊断病情参考信息。是否可以畅想下,未来足不出户在家就可以完成部分疾病的诊断,或者可以开发出线上诊断服务,减少去医院的次数?

pip install -r requirements.txt 基于医学知识库的LoRA权重文件 百度网盘下载地址: https://pan.baidu.com/s/1jih-pEr6jzEa6n2u6sUMOg?pwd=jjpf HuggingFace 下载地址: https://huggingface.co/thinksoso/lora-llama-med 基于医学文献的LoRA权重文件 百度网盘下载地址: https://pan.baidu.com/s/1jADypClR2bLyXItuFfSjPA?pwd=odsk#list/path=%2F 文件下载后,解压后的目录如下: 基于医学知识库: https://pan.baidu.com/share/init?surl=6oxcjzXnXjDpL8SKihgNxw&pwd=scir 基于医学知识库和医学文献: https://pan.baidu.com/s/1HDdK84ASHmzOFlkmypBIJw?pwd=scir

项目组提供了模型的训练数据集,共计八千余条,指令微调的训练集数据示例如下:

从对比结果中可以看出,本草 的表现要明显优于另外两个模型。 END![哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形 哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形](https://www.iwmyx.cn/wp-content/uploads/2024/07/frc-a9fe96e21cf88f32a26cd8b85c9fbbd6.jpeg)

#1.对 LLaMA 进行指令微调的 LoRA 权重文件#基于医学知识库lora-llama-med/ - adapter_config.json # LoRA 权重配置文件 - adapter_model.bin # LoRA 权重文件

#基于医学文献lora-llama-med-literature/ - adapter_config.json # LoRA 权重配置文件 - adapter_model.bin # LoRA 权重文件

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"./data_literature/liver_cancer.json中提供了其中的 1k 条训练样例。训练样本的示例如下:![哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形 哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形](https://www.iwmyx.cn/wp-content/uploads/2024/07/frc-77b6ff2cbe676ed07375e5e35989f6aa.png)

bash ./scripts/finetune.sh

![哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形 哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形](https://www.iwmyx.cn/wp-content/uploads/2024/07/frc-9b79ec0930225309cb6fd773a00c5c43.png)

![哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形 哈工大开源的本草[原名:华驼]: 基于中文医学知识的 LLaMA 微调模型,未来家庭医生的雏形](https://www.iwmyx.cn/wp-content/uploads/2024/07/frc-1eaa6988c81de06745f63e2776ef9b35.png)

© 版权声明

博主的文章没有高度、深度和广度,只是凑字数。利用读书、参考、引用、抄袭、复制和粘贴等多种方式打造成自己的纯镀 24k 文章!如若有侵权,请联系博主删除。

喜欢就点个赞吧

![【学习强国】[挑战答题]带选项完整题库(2020年4月20日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/timg-300x200.jpg)

![【学习强国】[新闻采编学习(记者证)]带选项完整题库(2019年11月1日更新)-武穆逸仙](https://www.iwmyx.cn/wp-content/uploads/2019/12/77ed36f4b18679ce54d4cebda306117e-300x200.jpg)